ChatGPT przejął cały świat szturmem na początku roku 2023, kiedy został udostępniony dla szerokiej publiki. Od tamtej pory sztuczna inteligencja zmieniła wiele branż na zawsze i doprowadziła do zmian na rynku pracy. Od początku roku OpenAI wypuściło liczne aktualizacje, które miały sprawiać, że model będzie coraz lepszy.

Jak się okazuje element „coraz lepszy” wcale się nie udał…

Progres, czy może regres sztucznej inteligencji?

OpenAI z miesiąca na miesiąc zaskakiwało nas kolejnymi aktualizacjami swojego AI. Zaczynając od premiery płatnego GPT4, poprzez implementacje 3.5 turbo, usunięcie poprzedniego modelu 3 i wiele innych zmian.

Z założenia każdy z tych update’ów ChataGPT miało sprawić, że stanie się on jeszcze przydatniejszy i jeszcze bardziej inteligentny.

Zresztą do pewnego momentu faktycznie, każda aktualizacja była progresem. Mogliśmy zaobserwować:

- lepsze rozumienie kontekstu

- większą dokładność w zadaniach związanych z matematyką

- dłuższy rozumiany kontekst

- bardziej poprawne odgadywanie intencji użytkownika

OpenAI postawiło sobie także za punk honoru uczynienie narzędzia bardziej przydatnym dla programistów. Z tego powodu dodali wiele możliwości z tym związanym, między innymi Chat zwracał kod w specjalnych formatowanych okienkach, a nawet umożliwiło natychmiastowe testowanie kodu przy odpowiedniej konfiguracji.

Warto też wspomnieć o najnowszej aktualizacji, która miała miejsce w listopadzie. Miała to być prawdziwa rewolucja. To premiera modelu GPT4-turbo, a także znaczne obniżenie cen. OpenAI dodało też wiele innych funkcji. Możesz o nich przeczytać w tym wpisie.

Z założenia, teraz, Chat po raz kolejny miał się stać jeszcze lepszy. Ale nie. Nie stało się tak…

Coraz więcej użytkowników chce zrezygnować ze swojej płatnej subskrypcji (czyli dostępu do GPT4) – Chat jest głupszy z każdą aktualizacją – mówią.

Trzęsienie ziemi w świecie AI – ChatGPT się zwija?

W listopadzie tego roku, niedługo po ostatniej aktualizacji wprowadzonej przez OpenAI na oficjalnym forum ChatGPT rozpoczęła się zażarta dyskusja dotycząca tego, jakie doświadczenia mają użytkownicy z przyjaznym robotem po ostatniej aktualizacji. Jak się okazuje, w zdecydowanej większości bardzo negatywne.

Przyjrzymy się kilku spośród setek negatywnych komentarzy:

Zauważyłem to samo, jakość odpowiedzi gwałtownie spadła. Kiedy zadaję jej pytania techniczne, lubi teraz podawać ponumerowaną listę uogólnionych punktów, zamiast po prostu zrozumieć moje intencje i odpowiedzieć odpowiednio, jak zrobiłaby to osoba. Muszę marnować dodatkowe podpowiedzi, aby zrozumieć, że chcę bardziej bezpośredniej i angażującej odpowiedzi…

To prawda, wielu użytkowników także zgłasza, że ChatGPT w wersji 4 odpowiada zdecydowanie bardziej ogólnie na pytania niż jeszcze przed 2 miesiącami. Częściej też „zasłania się” formułami w stylu „Nie jestem w stanie odpowiedzieć, bo…”

Szczególnie duże problemy zauważają programiści, którzy używali GPT do przyśpieszenia swojej pracy:

Kodowanie w ChatGPT 4.0 staje się coraz trudniejsze z każdym tygodniem. Oto co zauważyłem:

- Wydaje się, że model nie pamięta już historii konwersacji.

- Historia nie jest już nawet w pełni przechowywana; brakuje całych części.

- Utworzony kod, zawierający błędy, jest nagle obcinany lub całkowicie zmieniany.

- Kazałem ChatGPT samemu generować podpowiedzi, aby uniknąć tych błędów, ale to wcale nie pomaga. Za każdym razem jest źle.

- Inteligencja kodowania jest coraz gorsza. Nawet małe błędy wciąż się powtarzają, a model nie jest już w stanie ich rozwiązać.

- Model zawsze chce podzielić kod na wiele części, więc sam spędzasz ogromną ilość czasu na wycinaniu i wklejaniu, a pojawiają się nowe błędy.

I jeszcze inny użytkownik:

Ignoruje moje instrukcje w tej samej wiadomości. Nie potrafi zrozumieć, czego potrzebuję. Muszę ciągle powtarzać, tak jak chciałbym, aby odpowiedział na każdą wiadomość, ponieważ poprzednie zapomina i ignoruje.

Najgorsze jest to, że jest tak WOOOOLNY i pełen błędów. Co kilka wiadomości generuje błąd, który powtarza się aż do odświeżenia strony.

Inne uwagi

Inni użytkownicy zgłaszają także:

- wolniejsze odpowiedzi ze strony ChatGPT4 niż wcześniej

- mniej dokładne odpowiedzi

- niepamiętanie kontekstu

- prompty (komendy), które działały miesiąc wcześniej, dają teraz zupełnie inne rezultaty, albo nie działają

- Chat odmawia odpowiedzi w większej ilości tematów niż wcześniej

Warto też wspomnieć o „funkcjonalnościach” dodanych w poprzedniej aktualizacji, czyli o tak zwanych GPTs. To wbudowani w ChatGPT asystenci, których może zaprojektować sam użytkownik. Jednak jak zgłaszają internauci, GPTs nie przekraczają inteligencją zwykłego GPT4 niezależnie od zastosowanych komend.

Również mi, regularnemu użytkownikowi oprogramowania udało się zauważyć, że Chat stał się zdecydowanie gorszy w organizowaniu informacji. Odmawia także stosowania wymaganego formatowania. Polecenia, które wykonywał wcześniej bez zająknięć (np. utworzenie tabeli), najczęściej teraz skutkują odmową ze strony sztucznej inteligencji.

Co na to OpenAI?

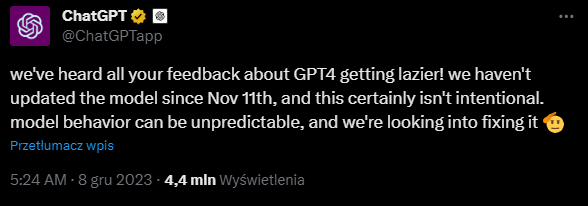

Bardzo szybko w odpowiedzi na niepochlebne opinie przewijające się przez forum ChatGPT, a także poprzez inne kanały, takie jak platforma X, pojawił się komunikat samego OpenAI. Wklejamy go poniżej.

Jeszcze tłumaczenie na polski: Słyszeliśmy wszystkie wasze opinie na temat tego, że GPT4 staje się coraz bardziej leniwy! Nie aktualizowaliśmy modelu od 11 listopada i z pewnością nie jest to zamierzone. Zachowanie modelu może być nieprzewidywalne i staramy się to naprawić

Co oznacza dla nas ten komentarz, choć nie mówi wcale tak wiele?

Że faktycznie pojawiły się problemy. Nie jest to kwestia, że użytkownicy oduczyli się prawidłowego promptowania, albo że mają problemy z obsługą programu. Ostatnie aktualizacje ChataGPT faktycznie pogorszyły wydajności oprogramowania.

Czemu to się wydarzyło? Teorie.

Na podstawie komentarzy użytkowników z już wcześniej wspomnianego wpisu blogowego, a także innych głosów, które można było wyczytać na X, możemy snuć teorie, które doprowadziły do obecnego stanu sztucznej inteligencji.

Jedna z nich mówi o tym, że wraz z ostatnim ZNACZNYM obniżeniem kosztów tokenów w API, OpenAI musi liczyć się ze zdecydowanie większą ilością zapytań trafiającą do ich czatbota.

Oznacza to, że moc obliczeniowa musi być podzielona przez zdecydowanie więcej użytkowników, co w efekcie może oznaczać spadek jakości odpowiedzi.

Kolejna teoria mówi o tym, że jest to działanie zupełnie celowe, mające na celu optymalizację kosztów. OpenAI według tej teorii testuje, jak bardzo można obniżyć jakość odpowiedzi bez dużej utraty subskrybentów.

Następna teoria sugeruje, że OpenAI przygotowuje się do premiery ChatGPT5 na początku roku 2024. Według tak twierdzących, model miałby mieć wyższą cenę niż GPT4 i być kolejnym poziomem subskrypcji. Ograniczenie funkcjonalności GPT4 miałoby skłonić użytkowników do zakupu „piątki”.

A jaka jest prawda? Najpewniej się nie dowiemy, o ile OpenAI samo tego nie ogłosi. Fakty są też takie, że wiedza większości użytkowników na temat AI jest dalej ograniczona i jeśli wierzyć tłumaczeniom OpenAI, duże modele językowe są nieprzewidywalnymi organizmami. Innymi słowy, sami mogą nie wiedzieć, z czego wynika obecna sytuacja.

Zachęcamy do dalszego obserwowania bloga z jeszcze większą dozą ciekawych informacji ze świata marketingu online.